混淆矩陣是一個用來衡量模型效能的工具。這使得資料科學家可以分析並優化模型。因此,在學習機器學習時,我們必須要學會使用混淆矩陣。此外,本文章還會介紹 accuracy、recall、precision、和 F1 score。

混淆矩陣

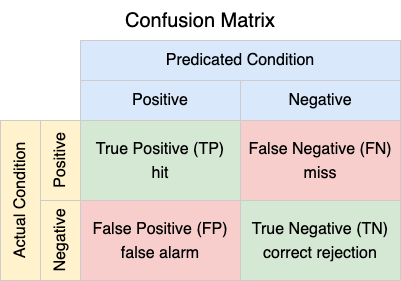

混淆矩陣由四種情況組成,如下。

各種情況的意義如下:

- True Positive (TP):實際上是 positive 且預測為 positive。

- 如,圖中的物件是狗,而模型認定是狗。

- False Negative (FN):實際上是 positive 但預測為 negative。

- 如,圖中的物件是狗,而模型認定不是狗。

- False Positive (FP):實際上是 negative 但預測為 positive。

- 如,圖中的物件不是狗,而模型認定是狗。

- True Negative (TN):實際上是 negative 且預測為 negative。

- 如,圖中的物件不是狗,而模型認定不是狗。

Accuracy

Accuracy 衡量正確預測的情況(TP 和 TN)佔所有的情況的比率。也就是,accuracy 衡量 actual condition 被正確地識別出來的比率。所以,accuracy 回答了一個問題:模型正確預測的機率是多少?

Recall

Recall 衡量 true positive 佔 actual positive 的比率。也就是,recall 衡量 actual positive 被正確地識別出來的比率。所以,recall 回答了一個問題:當是 actual positive 時,模型正確預測的機率是多少?

Precision

Precision 衡量 true positive 佔 predicated positive 的比率。也就是,precision 衡量 predicated positive 中正確的比率。所以,precision 回答了一個問題:當模型預測為 positive 時,正確的機率是多少?

F1-Score

F1-score 是 recall 和 precision 的 harmonic mean,用來衡量模型的精確度。當模型的 recall 很高時,有可能它的 precision 很低,反之亦然。一個好的模型最好能平衡 recall 和 precision,並且盡量讓它們很高。因此,我們需要一個 metric,如同 F1-score,可以同時考慮 recall 和 precision。

結語

除了本文章中介紹的 accuracy、recall、precision、和 F1 score 之外、混淆矩陣還可以產生出很多其他的 metrics。有了這些 metrics,我們才可以衡量模型的效能。